Última actualización: 25 de abril de 2024

¿Se siente abrumado por la cantidad de información en línea? ¿Tiene problemas para mantenerse al día con las tendencias en las redes sociales? ¿Cómo ordenar la información relevante entre esta abundancia de información?

Aquí es donde entra en juego el web scraping. Esta formidable técnica permite recopilar datos específicos en las redes sociales para identificar tendencias.

En este artículo, te revelaremos los secretos del web scraping para seguir las tendencias de las redes sociales. Prepárate para descubrir cómo esta técnica puede transformar la forma en que consumes información y ayudarte a estar a la vanguardia de tu mundo en línea.

¿Qué es el web scraping?

Le web scraping es una técnica que permite recopilar información desde sitios web automáticamente. Podemos imaginar un pequeño robot que navega por un sitio web y recopila toda la información interesante que allí encuentra.

Por ejemplo, para saber cuántas fotos de gatos hay en un sitio, puedes enviar un robot para que cuente la cantidad de fotos de gatitos y lo informe.

El web scraping también se puede utilizar para recopilar otros tipos de información, como por ejemplo:

- En las datos de identificación de usuarios, como nombres de usuario, direcciones de correo electrónico, números de teléfono, etc.

- Información del producto, como descripciones, imágenes, precios, reseñas, calificaciones, etc.

- Le contenido de redes sociales, como publicaciones, me gusta, comentarios, acciones, etc.

- Datos de investigación, como resultados de búsqueda, tendencias, palabras clave, hashtags, etc.

- Medios, como imágenes, videos, archivos de audio, etc.

- Datos financieros, como acciones, tipos de cambio, transacciones, etc.

Las empresas suelen utilizar web scraping para comprender mejor su mercado y mejorar su estrategia de marketing.

¿Cómo usar web scraping para seguir las tendencias de las redes sociales?

Para usar web scraping para rastrear las tendencias de las redes sociales, siga estos pasos:

1) Identificar redes sociales relevantes

En primer lugar, es necesario identificar las redes sociales relevantes para eliminar. Dependiendo de sus necesidades, puede resultar útil eliminar una o más redes sociales, como Facebook, Twitter, Instagram, LinkedIn, etc.

2) Seleccione los datos a recopilar

Una vez seleccionadas las redes sociales, es importante determinar la información relevante a extraer. De hecho, pueden ser publicaciones, me gusta, comentarios, acciones compartidas, hashtags, etc. Es fundamental seleccionar información que esté relacionada con los objetivos de la recopilación de datos.

3) Elija herramientas de web scraping

Hay muchas herramientas de web scraping disponibles en el mercado. Es importante elegir el que mejor se adapte a las necesidades de recopilación de datos.

Estos son algunos criterios a tener en cuenta:

- Complejidad de los sitios web para raspar.

- Información a recopilar.

- Características necesarias.

- Costos.

- Aspectos judiciales.

4) Escriba el código de raspado

Una vez elegida la herramienta, para extraer los datos deseados, a menudo es necesario escribir un código específico. Esto se puede lograr utilizando un lenguaje de programación como raspado web con Python, que es especialmente adecuado para esta tarea.

Sin embargo, también existen herramientas de web scraping que no requieren habilidades de codificación, para las personas que prefieren un enfoque más simple.

5) Raspar datos

Ahora es el momento de extraer los datos utilizando la herramienta de extracción web elegida. Los datos se pueden almacenar en una base de datos o en un archivo CSV para su posterior análisis.

6) Analizar los resultados

Finalmente, es necesario analizar los resultados para comprender las tendencias y los conocimientos. Puede utilizar herramientas de análisis de datos como Excel, Tableau o herramientas específicas para el análisis de redes sociales, como Hootsuite o Sprout Social.

Las herramientas de web scraping más utilizadas

Datos brillantes

La primera herramienta que recomendamos es Datos brillantes, una plataforma de recopilación de datos basada en la nube. Con esta herramienta, puede recuperar y analizar fácilmente datos estructurados y no estructurados de millones de sitios web.

Además, la herramienta insignia de Bright Data es el recopilador de datos, que permite a los usuarios extraer múltiples datos de cualquier sitio web público. Para ello, activa plantillas de web scraping listas para usar.

Además, esta plataforma ofrece una solución sencilla y personalizada para la extracción de datos. Puede recopilar datos automáticamente de diferentes sitios web y ofrece una variedad de formatos de salida como JSON, CSV, Excel o HTML, así como un método de recuperación variado, como API, correo electrónico o Google Cloud nuevamente.

En resumen, Bright Data es la herramienta perfecta para recuperar y analizar datos en la web de manera eficiente.

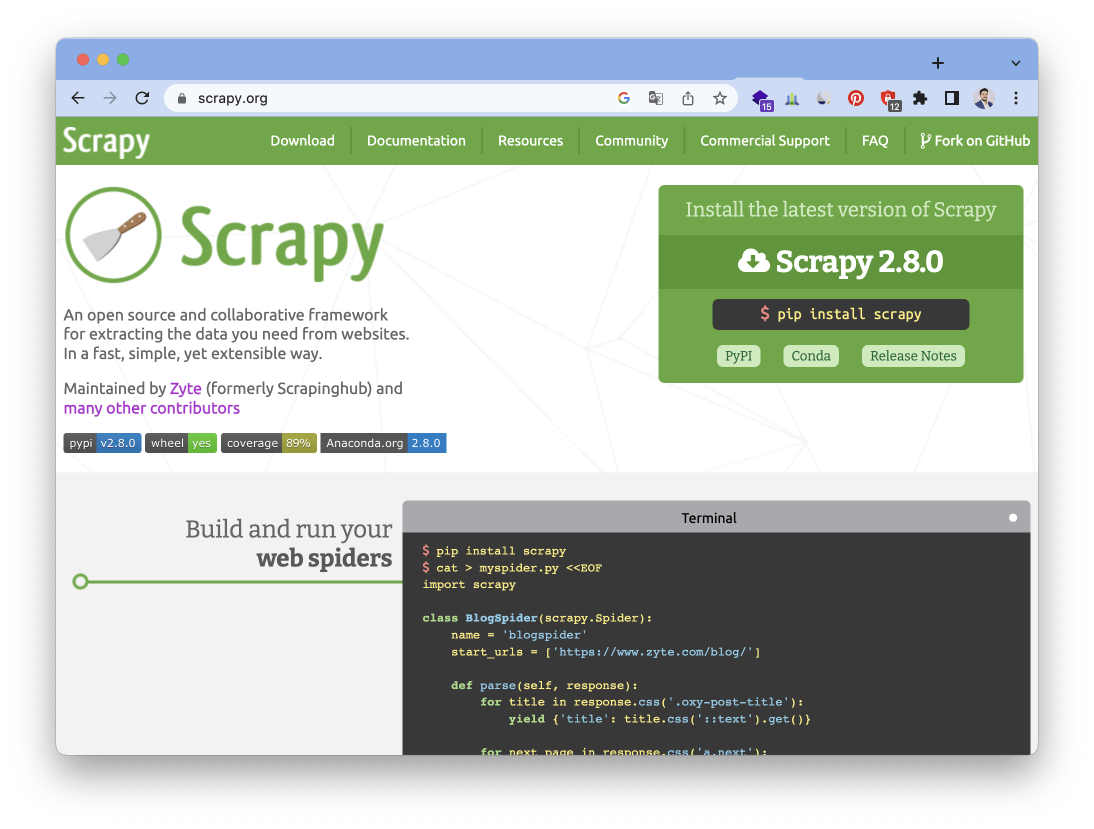

Scrapy

La segunda herramienta que les presentamos es Scrapy, un marco de web scraping de código abierto basado en Python. Scrapy está especialmente diseñado para extraer datos a gran escala de sitios web complejos, como redes sociales y sitios de comercio electrónico.

Además, Scrapy ofrece muchas funciones avanzadas para facilitar la extracción de datos, como administración de cookies, administración de conexiones y administración de proxy. También permite almacenar los datos recopilados en diferentes formatos, como CSV, JSON o XML.

WebHarvy

La tercera herramienta que le presentamos es WebHarvy, una herramienta de web scraping de escritorio que le permite extraer datos de sitios web mediante una interfaz gráfica de usuario. A diferencia de las otras herramientas presentadas anteriormente, WebHarvy está diseñada para usuarios sin conocimientos de programación y le permite extraer datos de varias páginas web a la vez.

Además, WebHarvy ofrece varias funciones avanzadas, como la capacidad de resolver captchas, utilizar proxies, exportar datos a diferentes formatos y programar tareas.

Los datos extraídos se pueden exportar a varios formatos, incluidos CSV, TSV, XML, JSON, SQL y HTML. También es posible exportar datos directamente a bases de datos como MySQL, SQL Server y Oracle.

Hermosa sopa

Si está buscando una herramienta de raspado web basada en Python, Beautiful Soup es una biblioteca que debe considerar. Esta biblioteca le permite extraer datos de archivos HTML y XML atravesando árboles HTML y XML para extraer datos específicos, como etiquetas o atributos.

Además, Beautiful Soup ofrece funciones avanzadas para facilitar la extracción de datos, como la capacidad de buscar datos basándose en patrones específicos o utilizar expresiones regulares para extraer datos más complejos.

Selenio

Finalmente, la última herramienta que le ofrecemos es Selenium, una herramienta de web scraping de código abierto que le permite controlar un navegador web para extraer datos de sitios web.

A diferencia de otras herramientas de scraping, Selenium se usa comúnmente para extraer datos de sitios web dinámicos, como redes sociales o sitios de comercio electrónico. De hecho, permite simular el comportamiento del usuario e interactuar con elementos de la página web, lo que lo hace especialmente adecuado para extraer datos de sitios web complejos.

Selenium también ofrece la capacidad de controlar varios navegadores diferentes, como Chrome, Firefox, Safari e Internet Explorer. Esto permite a los usuarios elegir el navegador que mejor se adapte a sus necesidades.

Necesidad de ayuda ? Haz tu pregunta, FunInformatique te respondere