Dernière mise à jour : 25 avril 2024

Vous sentez-vous submergé par la masse d’informations en ligne ? Vous avez du mal à suivre les tendances sur les réseaux sociaux ? Comment trier les informations pertinentes parmi cette abondance d’informations ?

C’est là que le web scraping entre en jeu. Cette technique redoutable permet de collecter des données spécifiques sur les réseaux sociaux pour identifier les tendances.

Dans cet article, nous allons vous dévoiler les secrets du web scraping pour suivre les tendances des réseaux sociaux. Préparez-vous à découvrir comment cette technique peut transformer votre façon de consommer l’information et vous aider à être à la pointe de votre univers en ligne.

Qu’est-ce que le web scraping ?

Le web scraping est une technique qui permet de collecter des informations à partir de sites web de manière automatique. On peut imaginer un petit robot qui parcourt un site web et qui collecte toutes les informations intéressantes qu’il y trouve.

Par exemple, pour savoir combien il y a de photos de chats sur un site, on peut envoyer un robot pour qu’il compte le nombre de photos de chatons et qu’il le communique.

Le web scraping peut également être utilisé pour collecter d’autres types d’informations, telles que :

- Les données d’identification des utilisateurs, telles que les noms d’utilisateur, les adresses e-mail, les numéros de téléphone, etc.

- Des informations de produits, telles que les descriptions, les images, les prix, les commentaires, les notes, etc.

- Le contenu sur les réseaux sociaux, telles que les publications, les likes, les commentaires, les partages, etc.

- Les données de recherche, telles que les résultats de recherche, les tendances, les mots clés, les hashtags, etc.

- Les médias, telles que les images, les vidéos, les fichiers audio, etc.

- Les données financières, telles que les actions, les taux de change, les transactions, etc.

Les entreprises utilisent souvent le web scraping pour mieux comprendre leur marché et améliorer leur stratégie marketing.

Comment utiliser le web scraping pour suivre les tendances des réseaux sociaux ?

Pour utiliser le web scraping pour suivre les tendances des réseaux sociaux, il faut suivre les étapes suivantes:

1) Identifier les réseaux sociaux pertinents

Tout d’abord, il faut identifier les réseaux sociaux pertinents à scraper. Selon vos besoins, il peut être utile de scraper un ou plusieurs réseaux sociaux, tels que Facebook, Twitter, Instagram, LinkedIn, etc.

2) Sélectionner les données à collecter

Une fois les réseaux sociaux sélectionnés, il est important de déterminer les informations pertinentes à scraper. En effet, il peut s’agir de publications, de likes, de commentaires, de partages, de hashtags, etc. Il est essentiel de sélectionner les informations qui sont en lien avec les objectifs de collecte de données.

3) Choisir les outils de web scraping

Il existe de nombreux outils de web scraping disponibles sur le marché. Il est important de choisir celui qui convient le mieux aux besoins de collecte de données.

Voici quelques critères à prendre en compte:

- Complexité des sites web à scraper.

- Informations à collecter.

- Fonctionnalités nécessaires.

- Coûts.

- Aspects juridiques.

4) Écrire le code de scraping

Une fois l’outil choisi, pour scraper les données souhaitées, il est souvent nécessaire d’écrire un code spécifique. Cela peut être réalisé en utilisant un langage de programmation tel que le web scraping avec Python, qui est particulièrement adapté à cette tâche.

Toutefois, il existe également des outils de web scraping qui ne requièrent pas de compétences de codage, pour les personnes qui préfèrent une approche plus simple.

5) Scraper les données

Maintenant, il est temps de scraper les données en utilisant l’outil de web scraping choisi. Les données peuvent être stockées dans une base de données ou dans un fichier CSV pour une analyse ultérieure.

6) Analyser les résultats

Enfin, il faut analyser les résultats pour comprendre les tendances et les insights. Vous pouvez utiliser des outils d’analyse de données tels que Excel, Tableau, ou des outils spécifiques à l’analyse de réseaux sociaux, tels que Hootsuite ou Sprout Social.

Les outils de web scraping les plus utilisés

Bright Data

Le premier outil que nous vous conseillons est Bright Data, une plateforme de collecte de données basée sur le cloud. Grâce à cet outil, vous pouvez facilement récupérer et analyser des données structurées et non structurées provenant de millions de sites web.

De plus, l’outil phare de Bright Data est le Data Collector, qui permet aux utilisateurs d’extraire de multiples données à partir de n’importe quel site web public. Pour ce faire, il active des templates de web scraping prêts à l’emploi.

Par ailleurs, cette plateforme offre une solution simple et personnalisée pour l’extraction de données. Elle permet de collecter automatiquement des données à partir de différents sites web tout en offrant un choix de formats de sortie tels que JSON, CSV, Excel ou HTML, ainsi qu’une méthode de récupération variée, comme l’API, l’email ou encore Google Cloud.

En somme, Bright Data est l’outil parfait pour récupérer et analyser efficacement des données sur le web.

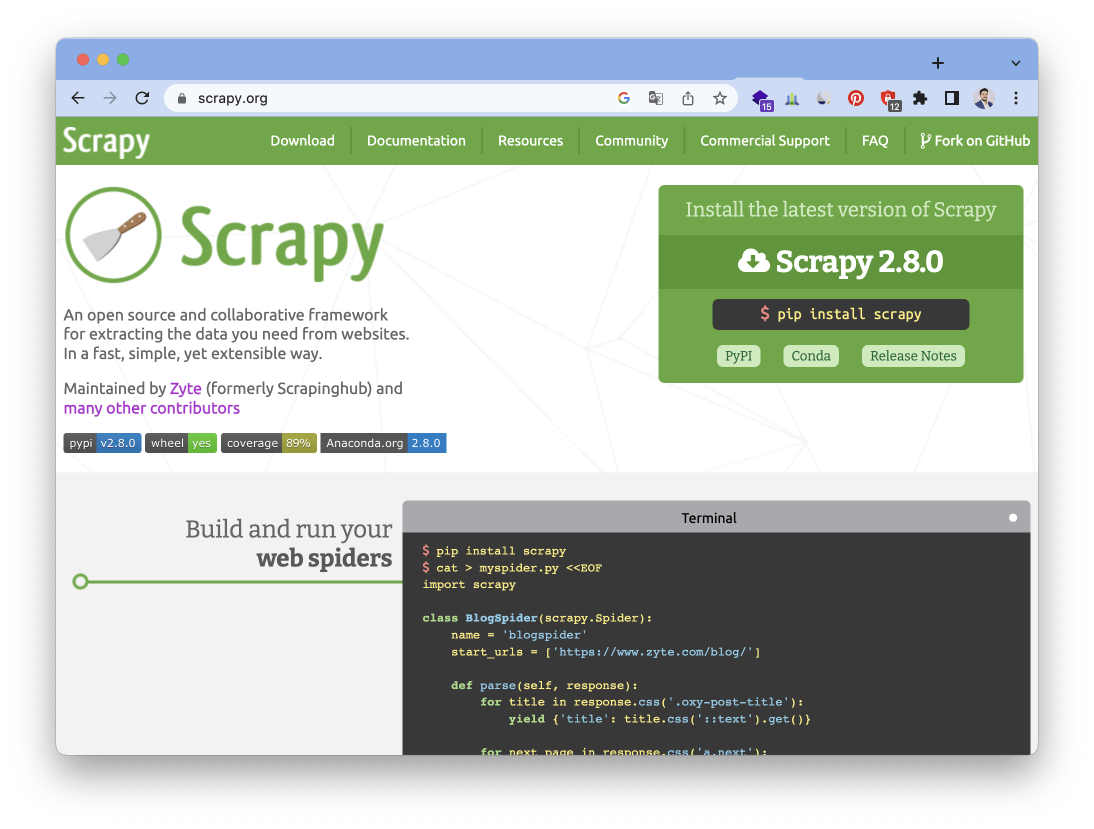

Scrapy

Le deuxième outil que nous vous présentons est Scrapy, un framework open source de web scraping basé sur Python. Scrapy est spécialement conçu pour extraire des données à grande échelle à partir de sites web complexes, tels que les réseaux sociaux et les sites d’e-commerce.

En outre, Scrapy offre de nombreuses fonctionnalités avancées pour faciliter l’extraction de données, comme la gestion des cookies, la gestion des connexions et la gestion des proxies. Il permet également de stocker les données collectées dans différents formats, tels que CSV, JSON ou XML.

WebHarvy

Le troisième outil que nous vous présentons est WebHarvy, un outil de web scraping de bureau qui permet d’extraire des données à partir de sites web en utilisant une interface utilisateur graphique. Contrairement aux autres outils présentés précédemment, WebHarvy est conçu pour les utilisateurs sans compétences en programmation et permet de scraper des données à partir de plusieurs pages web à la fois.

De plus, WebHarvy offre plusieurs fonctionnalités avancées telles que la possibilité de résoudre les captchas, d’utiliser des proxies, d’exporter les données vers différents formats et de planifier des tâches.

Les données extraites peuvent être exportées vers différents formats, y compris CSV, TSV, XML, JSON, SQL et HTML. Il est également possible d’exporter directement les données vers des bases de données telles que MySQL, SQL Server et Oracle.

Beautiful Soup

Si vous êtes à la recherche d’un outil de web scraping basé sur Python, Beautiful Soup est une bibliothèque que vous devriez considérer. Cette bibliothèque permet d’extraire des données à partir de fichiers HTML et XML en parcourant les arbres HTML et XML pour extraire des données spécifiques, telles que des balises ou des attributs.

De plus, Beautiful Soup offre des fonctionnalités avancées pour faciliter l’extraction de données, comme la possibilité de rechercher des données à partir de modèles spécifiques ou d’utiliser des expressions régulières pour extraire des données plus complexes.

Selenium

Enfin, le dernier outil que nous vous proposons est Selenium, un outil open source de web scraping qui permet de contrôler un navigateur web pour extraire des données à partir de sites web.

Contrairement aux autres outils de scraping, Selenium est couramment utilisé pour extraire des données à partir de sites web dynamiques, tels que les réseaux sociaux ou les sites d’e-commerce. En effet, il permet de simuler le comportement de l’utilisateur et d’interagir avec les éléments de la page web, ce qui le rend particulièrement adapté pour extraire des données à partir de sites web complexes.

Selenium offre également la possibilité de contrôler plusieurs navigateurs différents, tels que Chrome, Firefox, Safari et Internet Explorer. Cela permet aux utilisateurs de choisir le navigateur qui convient le mieux à leurs besoins.

Besoin d'aide ? Posez votre question, FunInformatique vous répondra.